Dans cet article, nous allons explorer le domaine du traitement de l’image en intelligence artificielle. Plus précisément, nous nous concentrerons sur les réseaux de neurones convolutifs, une méthode d’apprentissage profond utilisée pour la classification d’images, la détection d’objets et la reconnaissance de formes.

Les réseaux de neurones convolutifs sont un modèle de réseau à convolution largement utilisé dans le domaine du traitement de l’image. Ils sont capables d’apprendre à partir de grandes quantités de données et d’extraire des caractéristiques essentielles d’une image. Cela les rend particulièrement efficaces pour des tâches telles que la classification d’image et la détection d’objet.

En utilisant des algorithmes de convolution, de correction et de pooling, ces réseaux peuvent analyser une image en profondeur et identifier les éléments clés qui la composent. Ils sont également utilisés dans le traitement du langage naturel et l’apprentissage automatique.

Dans les prochaines sections de cet article, nous explorerons en détail le fonctionnement des réseaux de neurones convolutifs, en examinant les différentes étapes de leur architecture, notamment les couches de convolution, les couches de correction, les couches de pooling et les couches finales du réseau.

Au fil de cet article, nous discuterons également des différents types de familles de modèles de classification d’images, des hyper-paramètres et des applications des réseaux de neurones convolutifs. Nous aborderons également les limitations et les défis auxquels ces réseaux sont confrontés.

Prêt à découvrir comment une IA génère une image grâce aux réseaux de neurones convolutifs ? Alors continuons notre exploration!

Les différents types de familles de modèles de classification d’images

Avant l’avènement des réseaux de neurones convolutifs, les méthodes de classification d’images les plus couramment utilisées étaient les algorithmes des plus proches voisins (k-Nearest Neighbors), les machines à vecteurs de support ou les séparateurs à vaste marge (Support Vector Machine), et les forêts aléatoires (Random Forest). Cependant, ces méthodes ont été surpassées en termes de performance par les réseaux de neurones convolutifs, notamment en raison de leur capacité à extraire efficacement les caractéristiques discriminantes des images.

Prenons un exemple pour mieux comprendre les différences. Avec l’algorithme des k-Nearest Neighbors, la classification d’une image est basée sur la similarité de cette image avec les k images les plus proches dans l’ensemble de données d’entraînement. Cependant, cette méthode est sensible à la distribution des données et peut être coûteuse en termes de calcul. Les réseaux de neurones convolutifs, quant à eux, utilisent des filtres appris par l’apprentissage profond pour extraire automatiquement les caractéristiques pertinentes de l’image, ce qui permet une classification plus précise et efficace.

En résumé, les réseaux de neurones convolutifs ont révolutionné le domaine de la classification d’images en offrant des performances supérieures à celles des méthodes traditionnelles telles que les k-Nearest Neighbors, les Support Vector Machines et les Random Forests. Leur capacité à extraire efficacement les caractéristiques discriminantes des images en fait une approche puissante pour une grande variété de tâches de classification d’images.

Comment fonctionnent les réseaux de neurones convolutifs ?

Les réseaux de neurones convolutifs sont une approche de l’intelligence artificielle qui simule le fonctionnement du cerveau humain. Un neurone artificiel est une unité de calcul mathématique qui applique des opérations linéaires et non-linéaires sur les données d’entrée. Dans un réseau de neurones convolutifs, chaque neurone est associé à des poids et à un biais. Les poids déterminent l’importance relative des différentes caractéristiques de l’image, tandis que le biais permet de décaler la valeur de sortie du neurone. La somme pondérée des entrées d’un neurone, additionnée au biais, est passée dans une fonction d’activation qui introduit une non-linéarité dans le réseau.

Les réseaux de neurones convolutifs sont composés de différentes couches, telles que les couches de convolution, les couches de correction et les couches de pooling. Les couches de convolution effectuent des opérations de filtrage sur les images pour extraire les caractéristiques discriminantes. Les couches de correction appliquent des fonctions d’activation, telles que la fonction ReLU, pour introduire une non-linéarité dans le réseau. Les couches de pooling réduisent la taille des images en sous-échantillonnant les caractéristiques. Enfin, les couches finales du réseau, appelées couches entièrement connectées, combinent les caractéristiques extraites pour effectuer la classification de l’image.

Les réseaux de neurones convolutifs utilisent une architecture complexe pour traiter les images de manière progressive et extraire les caractéristiques importantes. Cela permet d’obtenir de meilleures performances de classification par rapport aux méthodes traditionnelles.

En résumé, les réseaux de neurones convolutifs sont capables de traiter efficacement les images en utilisant des opérations de convolution, de correction et de pooling. Leur architecture spécifique leur permet d’extraire les caractéristiques discriminantes des images et de les utiliser pour effectuer la classification. Cette approche a révolutionné le domaine du traitement de l’image en intelligence artificielle et trouve de nombreuses applications dans des domaines tels que la reconnaissance d’images, la détection d’objets et le traitement automatique du langage naturel.

Table 1: Architecture typique d’un réseau de neurones convolutifs

| Couche | Description |

|---|---|

| Entrée | Image d’entrée |

| Couches de convolution | Extraction des caractéristiques |

| Couches de correction | Introduction de la non-linéarité |

| Couches de pooling | Réduction de la taille de l’image |

| Couches entièrement connectées | Classification de l’image |

Qu’est-ce qu’une couche de convolution (CONV) ?

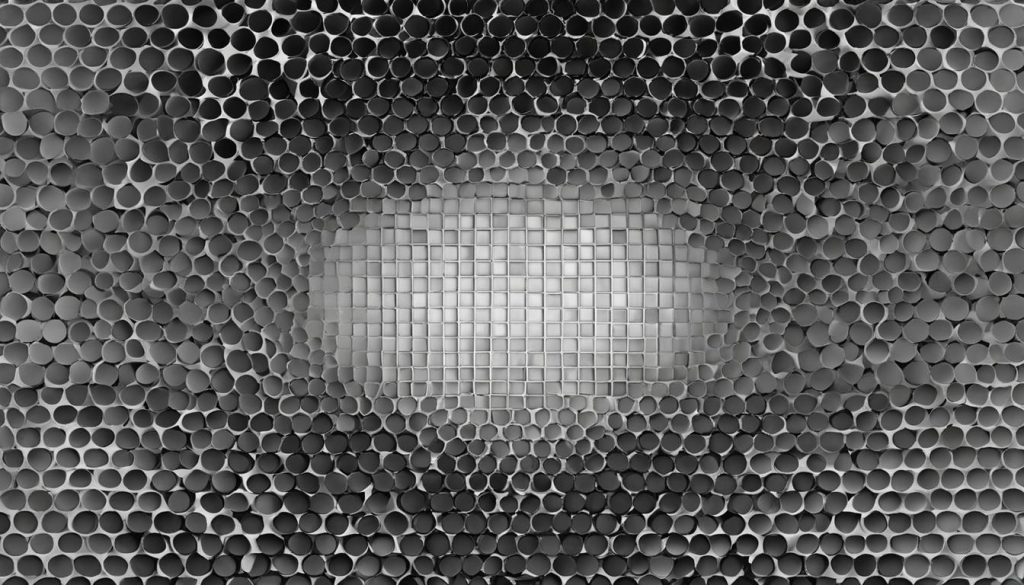

Une couche de convolution est une opération de filtrage appliquée à une image où un champ récepteur analyse une partie de l’image à l’aide d’un filtre. Cette opération effectue une multiplication des valeurs des pixels de l’image avec les poids du filtre, puis une somme de ces produits pour obtenir une valeur caractéristique. Cette opération est répétée sur toute l’image, ce qui donne une carte de caractéristiques représentant les différentes informations extraites de l’image.

La couche de convolution joue un rôle clé dans l’apprentissage des réseaux de neurones convolutifs. Elle permet au réseau de détecter des motifs et des structures spécifiques dans les images, ce qui est essentiel pour la classification et la reconnaissance des formes.

La taille du champ récepteur, également appelé taille du filtre, détermine la quantité d’informations locales analysées à chaque étape de la convolution. Plus la taille du champ récepteur est grande, plus le réseau sera capable d’extraire des caractéristiques complexes. Cependant, cela peut également augmenter la complexité et le temps de calcul du réseau.

La matrice de poids est un ensemble de paramètres appris par le réseau pour effectuer la convolution. Ces poids déterminent l’importance respective de chaque pixel dans l’image d’entrée. Ils sont ajustés pendant la phase d’apprentissage du réseau à l’aide de techniques telles que la rétropropagation et la descente de gradient.

En résumé, une couche de convolution dans un réseau de neurones convolutif permet d’extraire des caractéristiques discriminantes des images en appliquant des filtres et en réalisant des opérations de convolution sur les valeurs des pixels. Cette opération est fondamentale pour la classification d’images, la détection d’objets et d’autres tâches de traitement de l’image.

Comment fonctionne une couche de correction (ReLU) ?

Une couche de correction, également appelée couche d’activation, est une composante essentielle des réseaux de neurones convolutifs. Elle est appliquée à la sortie de la couche de convolution pour introduire une non-linéarité dans le réseau. La fonction d’activation la plus couramment utilisée est la fonction ReLU (Rectified Linear Unit), qui transforme toutes les valeurs négatives en zéro et conserve les valeurs positives.

Cette fonction de correction permet au réseau de détecter les caractéristiques complexes qui ne peuvent pas être représentées par une simple combinaison linéaire. En supprimant les valeurs négatives, la fonction ReLU introduit une non-linéarité dans le réseau, ce qui améliore sa capacité à apprendre et à extraire des informations discriminantes des images.

La couche de correction joue un rôle crucial dans la capacité du réseau à détecter des motifs et des structures complexes dans les images. En éliminant les valeurs négatives et en conservant les valeurs positives, la fonction ReLU permet de mettre en évidence les caractéristiques les plus significatives des images, facilitant ainsi la détection des objets et la classification précise.

Fonctionnement de la couche de correction :

- Le résultat de la couche de convolution est transmis à la couche de correction.

- La fonction ReLU est appliquée à chaque élément du résultat.

- Les valeurs négatives sont remplacées par zéro, tandis que les valeurs positives sont conservées.

- Le résultat corrigé est transmis aux couches suivantes pour poursuivre le processus de classification.

Ainsi, la couche de correction avec la fonction d’activation ReLU joue un rôle crucial dans la détection des caractéristiques complexes et la prise de décision dans les réseaux de neurones convolutifs.

| Entrée | Sortie |

|---|---|

| -2 | 0 |

| 0 | 0 |

| 3 | 3 |

Qu’est-ce qu’une couche de pooling (POOL) ?

La couche de pooling est une composante essentielle d’un réseau de neurones convolutifs. Elle joue un rôle important dans la réduction de la taille de l’image, ce qui permet de compresser l’information tout en préservant les caractéristiques importantes pour la classification. Le pooling est une opération de sous-échantillonnage qui consiste à regrouper les valeurs de plusieurs pixels en une seule valeur. Cela permet de réduire le nombre de caractéristiques présentes dans une région de la carte des caractéristiques, ce qui rend le réseau plus efficace en termes de calcul.

Le type de pooling le plus couramment utilisé est le max-pooling. Cette opération consiste à prendre la valeur maximale dans chaque région de pooling. Par exemple, si nous appliquons un max-pooling de taille 2×2 sur une région de 4 pixels, nous ne conserverons que la valeur maximale de ces 4 pixels. Cela permet de réduire la taille de l’image tout en conservant les caractéristiques les plus importantes.

La couche de pooling contribue également à la robustesse du réseau en rendant ce dernier moins sensible aux variations mineures de l’image, telles que les translations ou les petites déformations. En réduisant la taille de l’image, le pooling permet également de réduire le nombre de paramètres du réseau, ce qui facilite l’entraînement et accélère le calcul. Cependant, il est important de noter que le pooling peut également conduire à une perte d’information, notamment dans les régions de l’image où les caractéristiques sont moins présentes.

Le pooling est une opération de sous-échantillonnage qui permet de réduire la taille de l’image tout en préservant les caractéristiques importantes pour la classification.

| Avantages du pooling | Inconvénients du pooling |

|---|---|

| Compression de l’information | Perte d’information |

| Réduction du nombre de paramètres | Perte de précision |

| Robustesse aux variations de l’image | Adaptabilité au problème |

En résumé, la couche de pooling est une étape clé dans les réseaux de neurones convolutifs. Elle permet de réduire la taille de l’image tout en conservant les caractéristiques essentielles pour la classification. Le pooling contribue à la robustesse du réseau et facilite l’entraînement en réduisant le nombre de paramètres. Cependant, il est important de trouver le bon compromis entre la taille de l’image réduite et la perte d’information potentielle.

Comment fonctionne une couche « entièrement connectée » (FC) ?

Une couche entièrement connectée est située à la fin du réseau de neurones convolutif et utilise toutes les valeurs des caractéristiques extraites par les couches précédentes pour effectuer la classification de l’image. Chaque neurone de la couche entièrement connectée attribue une valeur de probabilité d’appartenance à chaque classe possible.

Cette couche permet de combiner les caractéristiques extraites pour obtenir une prédiction finale de la classe de l’image. Elle utilise des poids et des biais pour calculer les activations des neurones et produire une sortie. Les poids et les biais sont ajustés lors de l’apprentissage du réseau de neurones afin d’optimiser la performance du modèle.

La couche entièrement connectée peut être représentée comme une matrice de poids, où chaque ligne représente un neurone de la couche précédente et chaque colonne représente un neurone de la couche entièrement connectée. Les activations des neurones de la couche précédente sont multipliées par les poids correspondants et les résultats sont sommés pour chaque neurone de la couche entièrement connectée.

Enfin, des fonctions d’activation sont appliquées aux résultats pour introduire des non-linéarités dans le réseau. Ces fonctions permettent d’améliorer la capacité du réseau à modéliser des relations complexes entre les caractéristiques extraites et les classes cibles.

Exemple:

« La couche entièrement connectée utilise les informations extraites par les couches précédentes pour classer l’image en attribuant des probabilités d’appartenance à chaque classe. C’est une étape cruciale dans le processus de classification de l’image au sein d’un réseau de neurones convolutif. »

Qu’est-ce qu’une couche de perte (LOSS) ?

L’une des dernières étapes d’un réseau de neurones convolutifs est la couche de perte (LOSS), également connue sous le nom de fonction de perte. Cette couche est cruciale pour mesurer l’erreur entre la prédiction du réseau et la valeur réelle. L’objectif est de minimiser cette erreur afin de rendre le modèle de réseau plus précis dans ses prédictions.

La fonction de perte la plus couramment utilisée dans les tâches de classification est l’entropie croisée. Elle compare les distributions de probabilité entre la prédiction du modèle et la valeur réelle. Cette comparaison permet de calculer l’erreur globale entre les deux distributions et d’ajuster les poids du réseau en conséquence.

L’entropie croisée est basée sur le concept de variable aléatoire. Elle mesure la quantité d’information moyenne nécessaire pour représenter une variable aléatoire. Dans le contexte des réseaux de neurones convolutifs, cette fonction de perte permet d’évaluer la qualité des prédictions du modèle en fonction des données d’entraînement.

Exemple de fonction de perte : entropie croisée binaire

L’entropie croisée binaire est utilisée lorsque la tâche de classification est binaire, c’est-à-dire qu’il y a seulement deux classes possibles. Dans ce cas, la fonction de perte mesure l’erreur entre la prédiction du modèle et la valeur réelle pour chaque exemple d’entraînement.

« La fonction de perte de l’entropie croisée binaire est définie comme suit : L = – (y * log(p) + (1 – y) * log(1 – p)) »

Dans cette formule, y représente la valeur réelle (0 ou 1) et p représente la probabilité prédite par le modèle pour la classe positive. L’entropie croisée binaire mesure l’erreur en termes de divergence entre les distributions de probabilité.

En ajustant les poids du réseau à l’aide de la rétropropagation et de la descente de gradient, la couche de perte permet d’améliorer les performances du réseau de neurones convolutifs en minimisant l’erreur et en augmentant la précision des prédictions.

Hyper-paramètres des réseaux de neurones convolutifs

Les hyper-paramètres jouent un rôle essentiel dans l’apprentissage automatique des réseaux de neurones convolutifs. Ils déterminent la taille du réseau, les stratégies d’apprentissage et les valeurs des hyper-paramètres qui influencent la vitesse et la qualité de l’apprentissage. Le choix de ces hyper-paramètres est un processus itératif basé sur l’expérience et la connaissance du problème à résoudre.

La taille du réseau est l’un des hyper-paramètres les plus importants à prendre en compte. Un réseau plus grand peut capturer des caractéristiques plus complexes mais nécessite également plus de ressources de calcul. Il est essentiel de trouver le bon équilibre pour éviter le sur-apprentissage.

Les stratégies d’apprentissage, telles que le taux d’apprentissage et le choix de l’optimiseur, sont également des hyper-paramètres essentiels. Le taux d’apprentissage contrôle la rapidité avec laquelle le modèle apprend, tandis que le choix de l’optimiseur affecte la façon dont les poids du réseau sont ajustés. Trouver les bonnes valeurs pour ces hyper-paramètres peut considérablement influencer les performances du modèle.

Exemple de tableau des hyper-paramètres :

| Hyper-paramètre | Valeurs |

|---|---|

| Taille du réseau | Petit, moyen, grand |

| Stratégie d’apprentissage | Taux d’apprentissage : 0.001, 0.01, 0.1 Optimiseur : Adam, AdaGrad, RMSprop |

En conclusion, les hyper-paramètres des réseaux de neurones convolutifs sont des paramètres essentiels qui influencent l’apprentissage automatique. La sélection de la taille du réseau, des stratégies d’apprentissage et des valeurs des hyper-paramètres peut avoir un impact significatif sur les performances du modèle. Il est important de les ajuster avec soin et d’expérimenter différentes combinaisons pour obtenir les meilleurs résultats.

Applications des réseaux de neurones convolutifs

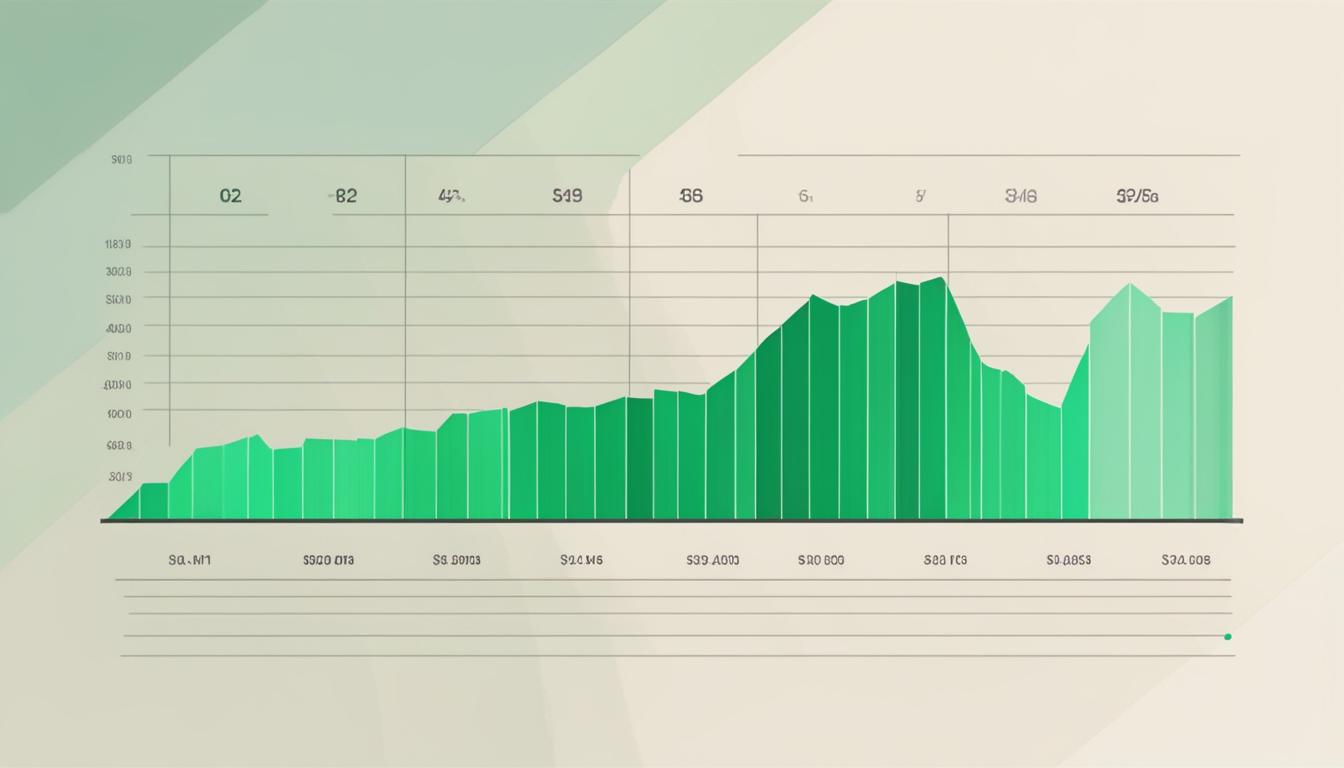

Les réseaux de neurones convolutifs ont révolutionné le domaine du traitement de l’image en intelligence artificielle. Leur capacité à apprendre à partir de grandes quantités de données et à extraire des caractéristiques discriminantes des images a ouvert de nombreuses possibilités d’application.

La reconnaissance d’images est l’une des applications les plus courantes des réseaux de neurones convolutifs. Grâce à leur capacité à détecter et à interpréter les motifs et les formes dans les images, ces réseaux sont utilisés pour la classification d’images dans divers domaines tels que la médecine, la sécurité et l’industrie.

Les réseaux de neurones convolutifs sont également utilisés dans la reconnaissance vocale pour convertir la parole en texte. En analysant les caractéristiques audio et en les comparant avec des modèles de langage, ces réseaux permettent une transcription précise de la parole, ce qui est essentiel dans de nombreux domaines tels que la transcription médicale, la dictée vocale et les assistants virtuels.

Le traitement automatique du langage naturel est une autre application des réseaux de neurones convolutifs. Ces réseaux sont capables de comprendre et de générer du langage humain, ce qui ouvre des possibilités dans la traduction automatique, la génération de texte, l’analyse de sentiment et bien d’autres domaines.

Enfin, les réseaux de neurones convolutifs sont également utilisés dans la création de deepfakes, une technique qui consiste à manipuler des images et des vidéos pour superposer des fichiers audio et vidéo existants sur d’autres médias. Bien que cette application soulève des questions éthiques et de sécurité, elle illustre la puissance des réseaux de neurones convolutifs en matière de traitement de l’image.

Résumé

En conclusion, les réseaux de neurones convolutifs sont utilisés dans de nombreuses applications, allant de la reconnaissance d’images à la classification d’images, en passant par la reconnaissance vocale et le traitement automatique du langage naturel. Leur capacité à extraire des caractéristiques discriminantes des images et à apprendre à partir de grandes quantités de données en fait des outils puissants pour résoudre des problèmes complexes. Toutefois, il convient de noter que l’utilisation de ces réseaux soulève également des questions éthiques et de sécurité, qui nécessitent une attention particulière.

| Domaine d’application | Exemples |

|---|---|

| Reconnaissance d’images | Classification d’images médicales, détection d’objets, reconnaissance faciale |

| Reconnaissance vocale | Transcription de la parole, assistants virtuels, traduction automatique |

| Traitement automatique du langage naturel | Analyse de sentiment, génération de texte, chatbots |

| Deepfake | Manipulation d’images et de vidéos pour créer des médias falsifiés |

Fonctionnement d’un réseau de neurones convolutif

Dans cette section, nous allons plonger plus en profondeur dans le fonctionnement d’un réseau de neurones convolutif. Ces réseaux sont spécialement conçus pour la classification d’images et utilisent des opérations de convolution, de pooling et de correction pour extraire les caractéristiques des images et les classer correctement.

La première étape du processus est la convolution, où un filtre parcourt l’image en effectuant une multiplication des valeurs des pixels avec les poids correspondants. Cette opération permet d’extraire les caractéristiques importantes de l’image. Ensuite, la fonction d’activation est appliquée pour introduire une non-linéarité dans le réseau et détecter les caractéristiques complexes.

Le pooling est ensuite utilisé pour réduire la taille de l’image en prenant la valeur maximale dans chaque région de pooling. Cette opération permet de comprimer l’information et de réduire le nombre de paramètres du réseau. Enfin, le réseau est entièrement connecté, ce qui signifie que toutes les caractéristiques extraites sont combinées pour effectuer la classification de l’image.

Rétropropagation et descente de gradient

Pour entraîner un réseau de neurones convolutif, nous utilisons la rétropropagation et la descente de gradient. La rétropropagation permet de calculer les gradients des poids et des biais du réseau en fonction de la fonction de perte, qui mesure l’écart entre les prédictions du réseau et les valeurs réelles.

La descente de gradient est alors utilisée pour ajuster les poids et les biais afin de minimiser la fonction de perte. Ce processus itératif est répété plusieurs fois sur l’ensemble des données d’entraînement afin d’améliorer les performances du réseau.

En résumé, un réseau de neurones convolutif utilise des opérations de convolution, de pooling et de correction pour extraire et combiner les caractéristiques des images, et la rétropropagation avec la descente de gradient pour ajuster les poids et les biais du réseau. Cette combinaison de techniques permet aux réseaux de neurones convolutifs d’atteindre des performances exceptionnelles dans la classification d’images.

Limitations et défis des réseaux de neurones convolutifs

Malgré leurs performances impressionnantes dans le domaine du traitement d’images, les réseaux de neurones convolutifs sont confrontés à certaines limites et défis. Comprendre et surmonter ces obstacles est essentiel pour exploiter pleinement leur potentiel.

Sur-apprentissage

L’un des principaux défis des réseaux de neurones convolutifs est le sur-apprentissage, également appelé overfitting en anglais. Cela se produit lorsque le modèle s’adapte trop étroitement aux données d’entraînement au point de ne pas généraliser correctement sur de nouvelles données. Pour éviter le sur-apprentissage, il est important d’utiliser des techniques de régularisation telles que le dropout ou la régularisation L1/L2, qui aident à limiter la complexité du modèle.

Interprétabilité

Une autre limitation des réseaux de neurones convolutifs est leur manque d’interprétabilité. En raison de leur architecture complexe et du grand nombre de paramètres, il peut être difficile de comprendre comment le modèle prend ses décisions. Cela peut poser un problème dans certaines applications sensibles où une explication claire des résultats est nécessaire. Des efforts de recherche sont en cours pour développer des techniques d’interprétabilité des modèles afin de mieux comprendre leur fonctionnement.

Réseaux de neurones très profonds

Les réseaux de neurones convolutifs peuvent être très profonds, avec de nombreuses couches. Cependant, l’utilisation de réseaux très profonds peut poser des problèmes de performance et de convergence lors de l’entraînement. Des techniques telles que la normalisation par lots (batch normalization) et l’utilisation d’architectures résiduelles (residual networks) ont été développées pour faciliter l’entraînement de réseaux profonds, mais cela reste un défi à prendre en compte lors de la conception du modèle.

| Défis | Solutions possibles |

|---|---|

| Sur-apprentissage | Utilisation de techniques de régularisation |

| Interprétabilité | Développement de techniques d’interprétabilité des modèles |

| Réseaux de neurones très profonds | Utilisation de techniques de normalisation et d’architectures résiduelles |

Conclusion

Nous avons vu comment les réseaux de neurones convolutifs ont révolutionné le domaine du traitement de l’image en intelligence artificielle. Grâce à leur capacité à apprendre à partir de grandes quantités de données et à extraire des caractéristiques discriminantes, ces réseaux ont ouvert de nombreuses possibilités d’application dans des domaines tels que la reconnaissance d’images, la détection d’objets et le traitement automatique du langage naturel.

Cependant, il est important de noter que les réseaux de neurones convolutifs ne sont pas sans limites. Le phénomène du sur-apprentissage peut se produire, où le réseau devient trop spécialisé dans les données d’entraînement et perd en généralisation. De plus, l’interprétation des résultats peut être difficile, car il n’est pas toujours clair comment les caractéristiques sont extraites et utilisées pour la classification.

Enfin, l’entraînement des réseaux de neurones très profonds peut poser des défis en termes de calcul et de temps nécessaire. Malgré ces limitations, les réseaux de neurones convolutifs restent une technologie prometteuse avec de nombreuses applications potentielles.

Ainsi, pour utiliser efficacement les réseaux de neurones convolutifs, une compréhension approfondie de leur fonctionnement et des méthodes appropriées est essentielle. En continuant à explorer et à améliorer ces architectures, nous pouvons exploiter tout leur potentiel pour résoudre des problèmes complexes.

FAQ

Comment fonctionne un réseau de neurones convolutif ?

Un réseau de neurones convolutif fonctionne en utilisant des opérations de convolution, de pooling et de correction pour extraire les caractéristiques des images et les classer correctement. La rétropropagation est utilisée pour ajuster les poids et les biais du réseau à l’aide de la descente de gradient, ce qui permet au réseau d’apprendre à partir des données d’entraînement.

Quels sont les différents types de familles de modèles de classification d’images ?

Les méthodes de classification d’images les plus couramment utilisées avant l’avènement des réseaux de neurones convolutifs étaient les algorithmes des plus proches voisins (k-Nearest Neighbors), les machines à vecteurs de support ou les séparateurs à vaste marge (Support Vector Machine), et les forêts aléatoires (Random Forest).

Qu’est-ce qu’une couche de convolution (CONV) ?

Une couche de convolution est une opération de filtrage appliquée à une image où un champ récepteur analyse une partie de l’image à l’aide d’un filtre. Cette opération permet d’extraire des caractéristiques de l’image en effectuant des multiplications et des sommes des valeurs des pixels de l’image avec les poids du filtre.

Comment fonctionne une couche de correction (ReLU) ?

Une couche de correction, ou d’activation, est appliquée à la sortie de la couche de convolution pour introduire une non-linéarité dans le réseau. La fonction d’activation la plus couramment utilisée est la fonction ReLU (Unité de rectification linéaire), qui transforme toutes les valeurs négatives en zéro et conserve les valeurs positives.

Qu’est-ce qu’une couche de pooling (POOL) ?

Une couche de pooling est une opération de sous-échantillonnage qui réduit la taille de l’image en réduisant le nombre de caractéristiques présentes dans une région de la carte des caractéristiques. Le pooling le plus couramment utilisé est le max-pooling, qui prend la valeur maximale dans chaque région de pooling.

Comment fonctionne une couche « entièrement connectée » (FC) ?

Une couche entièrement connectée utilise toutes les valeurs des caractéristiques extraites par les couches précédentes pour effectuer la classification de l’image. Chaque neurone de la couche entièrement connectée attribue une valeur de probabilité d’appartenance à chaque classe possible.

Qu’est-ce qu’une couche de perte (LOSS) ?

La couche de perte est la dernière couche du réseau de neurones convolutifs et mesure l’erreur entre la prédiction du réseau et la valeur réelle. Pour les tâches de classification, la fonction de perte la plus couramment utilisée est l’entropie croisée, qui compare les distributions de probabilité entre la prédiction du modèle et la valeur réelle.

Quels sont les hyper-paramètres dans l’apprentissage automatique ?

Les hyper-paramètres sont des paramètres du modèle et de l’algorithme qui contrôlent l’apprentissage automatique. Ils peuvent définir la taille du réseau, les stratégies d’apprentissage et les valeurs des hyper-paramètres influencent la vitesse et la qualité de l’apprentissage.

Quelles sont les applications des réseaux de neurones convolutifs ?

Les réseaux de neurones convolutifs ont de nombreuses applications, telles que la reconnaissance d’images, la classification d’images, la reconnaissance vocale et le traitement automatique du langage naturel. Ils sont utilisés pour la détection d’objets, la reconnaissance de formes et le deepfake.

Quelles sont les limites et les défis des réseaux de neurones convolutifs ?

Les réseaux de neurones convolutifs présentent des limites et des défis tels que le sur-apprentissage, la difficulté d’interprétation des résultats et l’entraînement des réseaux très profonds. Ces problèmes nécessitent une attention et des solutions adaptées.

Laisser un commentaire